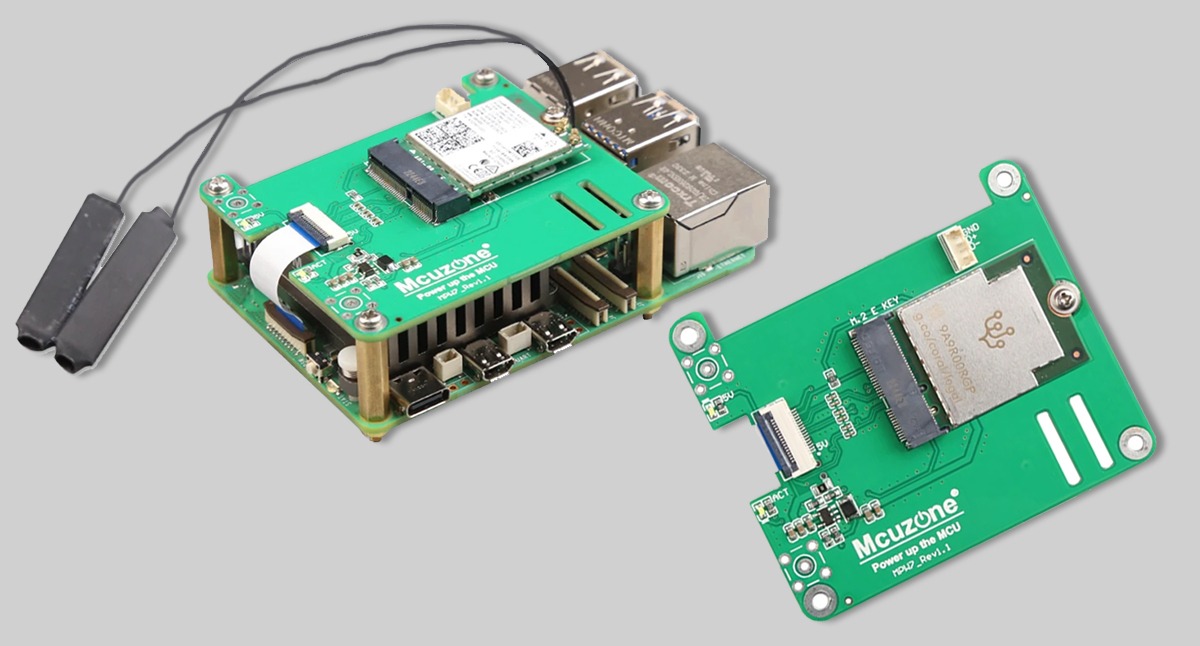

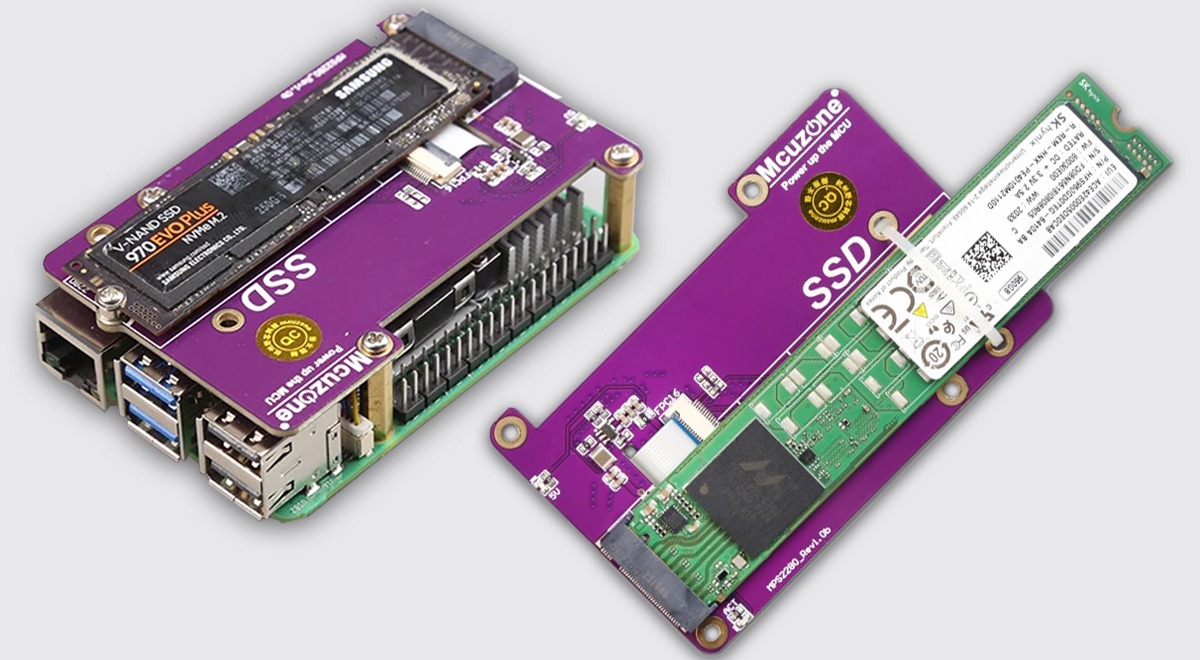

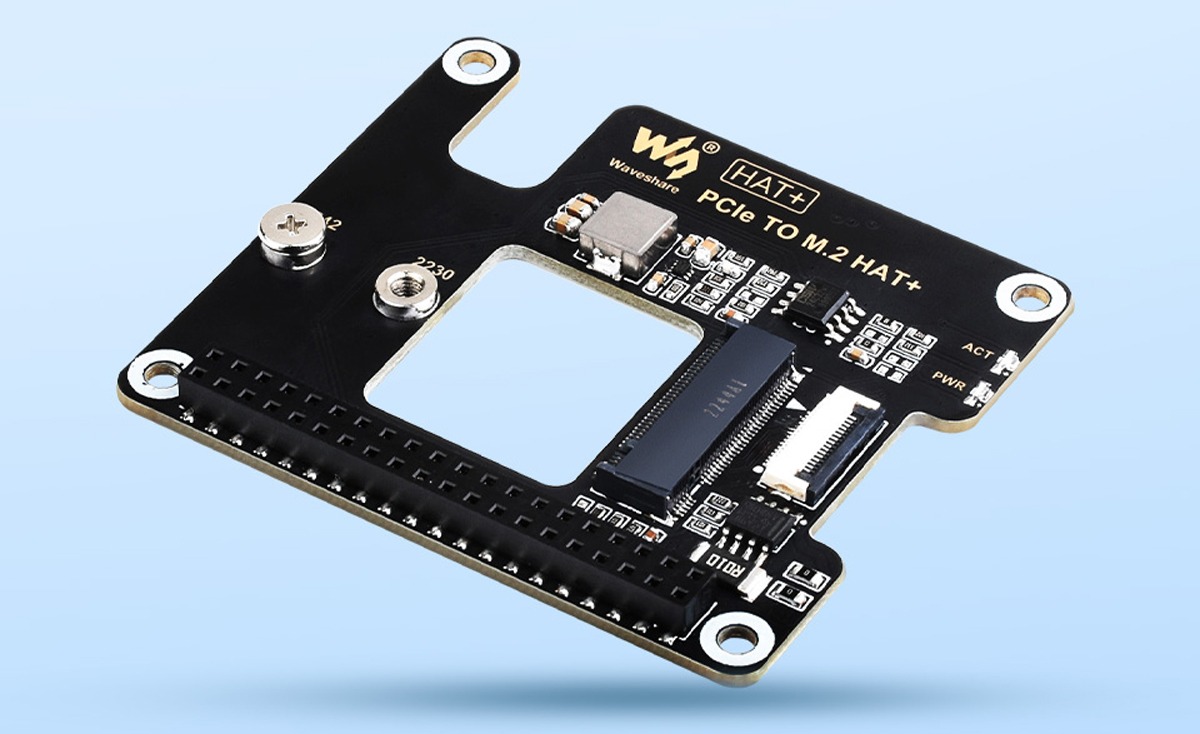

52Pi P02 — это плата расширения для Raspberry Pi 5, которая преобразует PCIe Pi в слот PCIe x1. Плата подключается к нижней части Pi и получает питание Pi с помощью встроенных Pogo-контактов. Плата поддерживает скорости PCIe Gen2/Gen3 и оснащена разъемом JST для внешнего источника питания.

Читать далее «Плата расширения 52Pi P02 PCIe для Raspberry Pi 5 имеет слот PCIe x1»