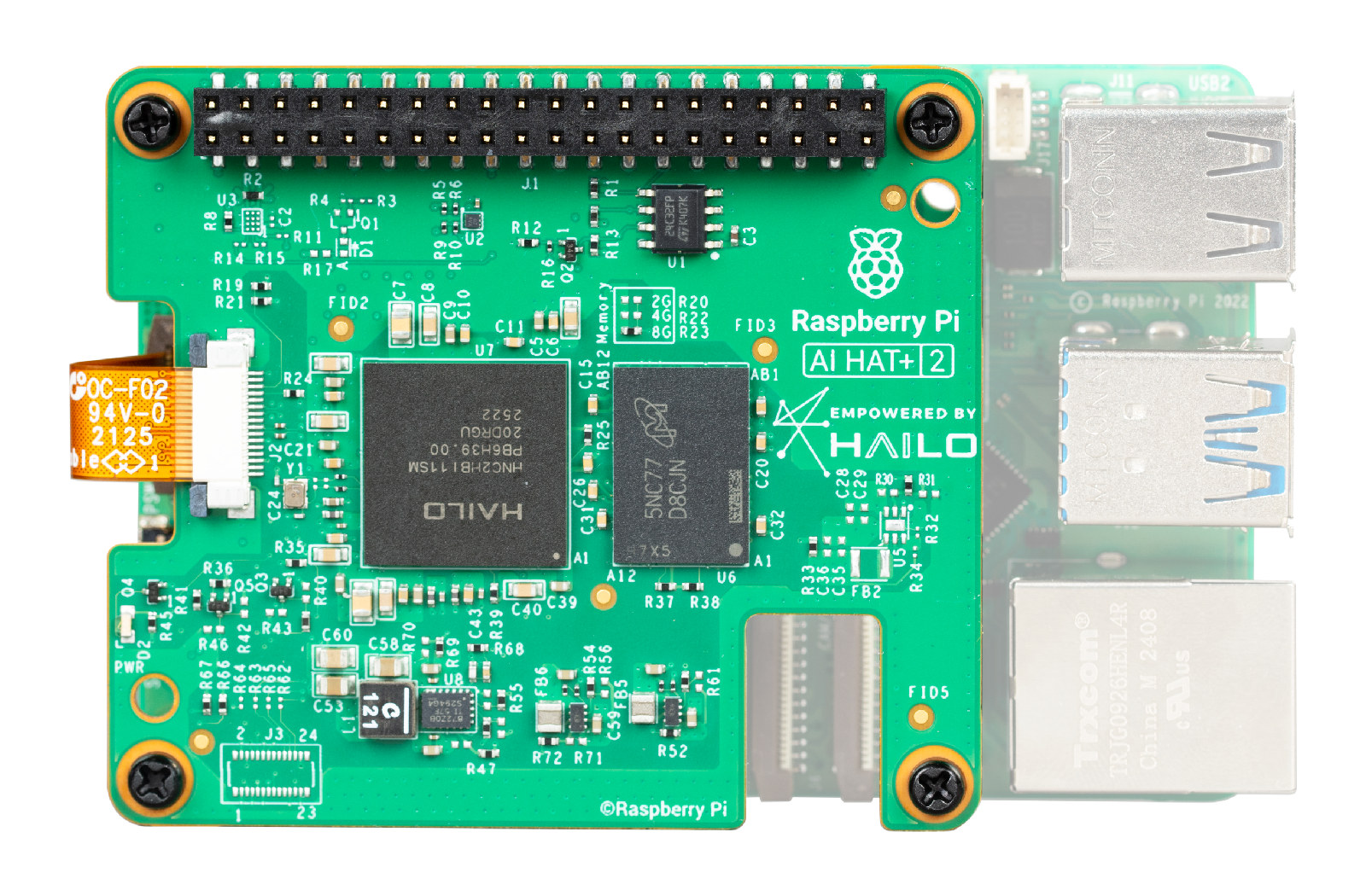

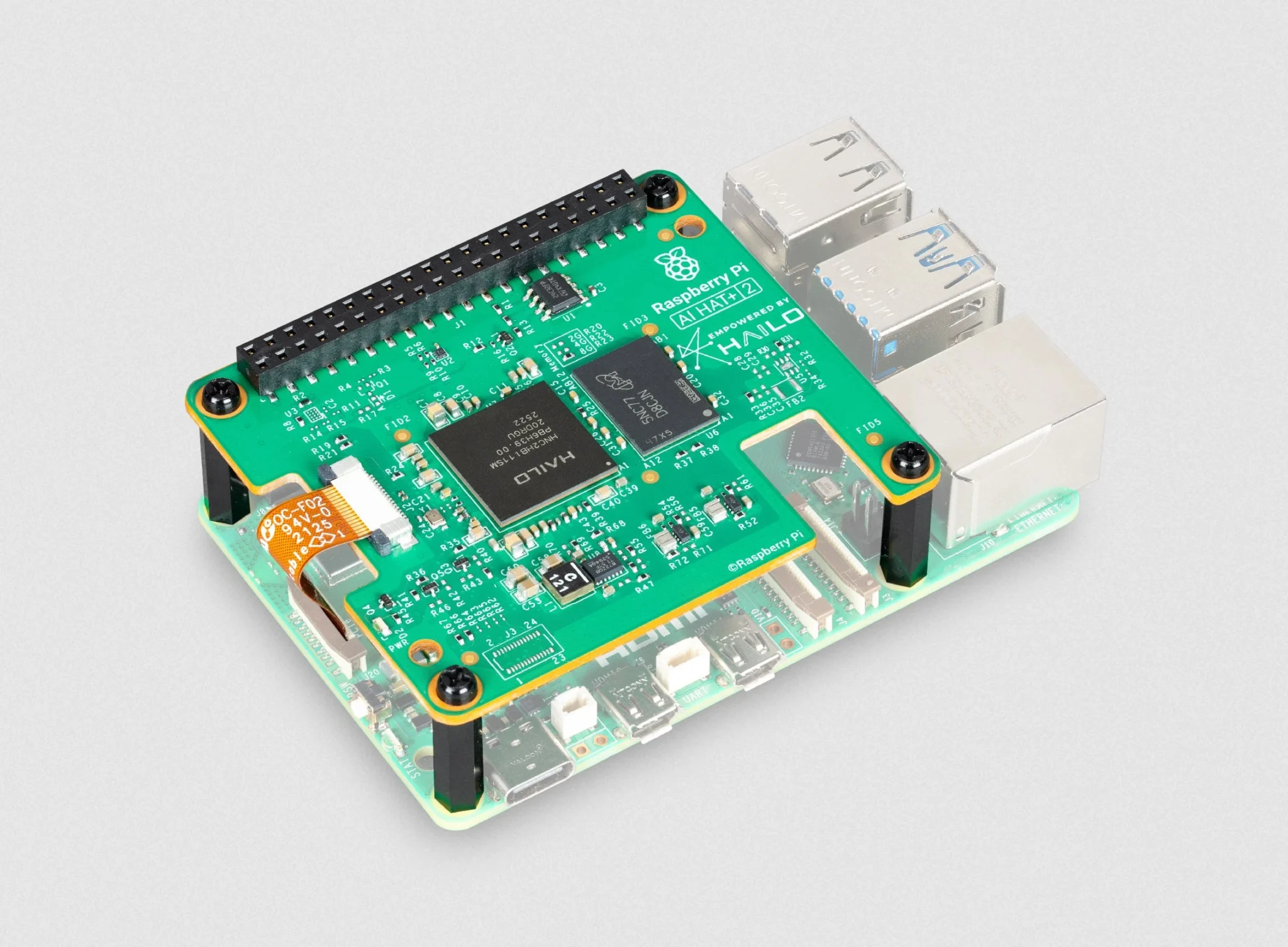

Raspberry Pi AI HAT+ 2 — это дополнительная плата на базе ИИ-ускорителя Hailo-10H с производительностью 40 TOPS с 8 ГБ выделенной встроенной оперативной памяти, которая добавляет Raspberry Pi 5 возможность работы с генеративным ИИ.

Показывая аналогичную производительность в задачах компьютерного зрения, что и плата первого поколения на базе Hailo-8 — Raspberry Pi AI HAT+ , AI HAT+ 2 также добавляет поддержку больших языковых моделей (LLM) и визуально-языковых моделей (VLM), работающих локально без необходимости доступа к интернету. Целевые области применения включают автономное управление процессами, безопасный анализ данных, управление объектами и робототехнику.

Характеристики Raspberry Pi AI HAT+ 2:

- ИИ-ускоритель – Hailo Hailo-10H

- ИИ-ускоритель с производительностью вывода 40 TOPS (INT4)

- Производительность для моделей компьютерного зрения сравнима с Raspberry Pi AI HAT+ (26 TOPS)

- 8 ГБ встроенной оперативной памяти

- Интерфейс подключения к хосту

- Разъем FPC PCIe Gen3 x1 для подключения к Raspberry Pi 5

- 40-контактный GPIO-разъем (сигналы Hailo-10H не задействованы, он лишь расширяет GPIO-разъем на плате Pi)

- Прочее

- Поставляется с подъемными заголовками высотой 16 мм, распорками и винтами для установки при наличии активного кулера Raspberry Pi 5

- Опциональный радиатор

- Габариты – 64.1 x 56.7 x 5.5 мм (совместима со стандартом Raspberry Pi HAT+)

- Диапазон рабочих температур – от 0°C до 50°C

- Жизненный цикл – в производстве как минимум до января 2036 года

Для начала работы потребуется актуальный образ Raspberry Pi OS, после чего система автоматически определит ускоритель Hailo-10H, который полностью интегрирован в программный стек для камер Raspberry Pi, в частности, в приложения для камер rpicam‑apps, libcamera и Picamera2. Модели генеративного ИИ можно найти на сайте Hailo и на GitHub , где также доступен Hailo-Ollama — совместимый с Ollama API, написанный на C++ поверх HailoRT. Лучший способ начать работу — ознакомиться с соответствующей документацией на сайте Raspberry Pi.

Пример поддерживаемых моделей:

- DeepSeek-R1-Distill – 1.5 миллиарда параметров

- Llama3.2 – 1 миллиард параметров

- Qwen2.5-Coder – 1.5 миллиарда параметров

- Qwen2.5-Instruct – 1.5 миллиарда параметров

- Qwen2 – 1.5 миллиарда параметров

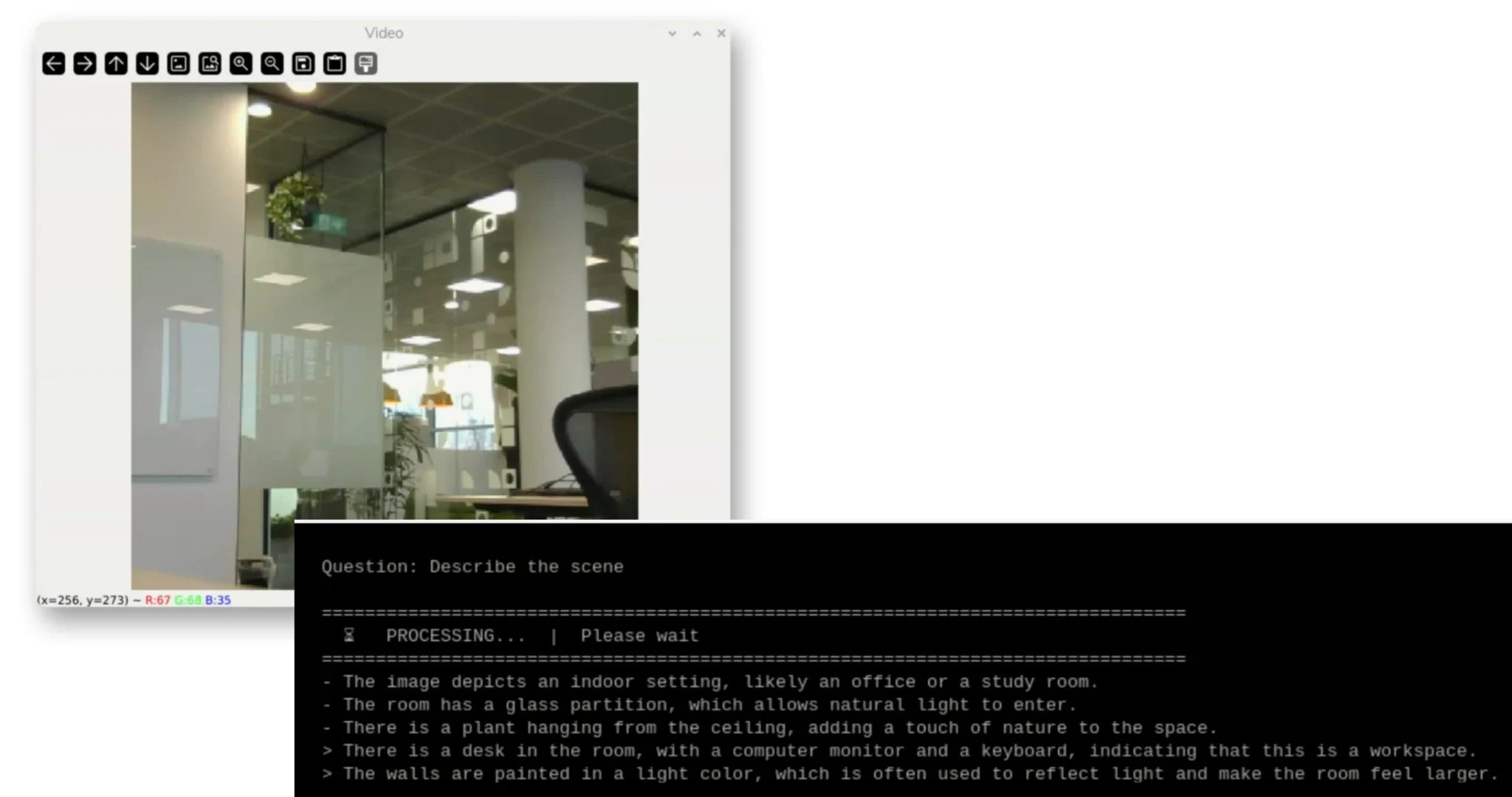

Модель не займет полностью 8 ГБ ОЗУ модуля, однако сообщается, что готовятся модели большего размера. Вот одно из демо с LLM.

Вывод из демонстрации визуально-языковой модели:

Raspberry Pi отправила образец через DHL на прошлой неделе, но он прибыл в пункт назначения всего пару минут назад, когда статья была почти готова. Вероятно, тестирование состоится на этих выходных. Устройство продается по цене 130 долларов США у авторизованных реселлеров Raspberry Pi, без учета доставки и налогов. Оно должно составить конкуренцию ИИ-ускорителям для LLM/VLM Rockchip RK1820/RK1828 , по которым нет четкой информации о ценах.

Выражаем свою благодарность источнику, с которого взята и переведена статья, сайту cnx-software.com.

Оригинал статьи вы можете прочитать здесь.