В поисках новых и интересных продуктов мы нашли серию DLAP Supreme от ADLINK, серию устройств Edge AI, на базе платформы NVIDIA Jetson AGX Orin. Но это не самое интересное, наше внимание привлекла поддержка технологии aiDAPTIV+ . Мы обнаружили, что aiDAPTIV+ AI представляет собой гибридное (программное и аппаратное) решение, которое использует легкодоступную недорогую флэш-память NAND для расширения возможностей графических процессоров для оптимизации и масштабирования работы с большими языковыми моделями (LLM) для малого и среднего бизнеса. Такая конструкция предлагает более рациональный подход, в отличие от традиционных методов, которые требуют значительных ресурсов и сложных вычислений, таких как Llama-2 7B.

Решение поддерживает до 70B параметров модели с низкой задержкой и высоконадежным хранилищем (100 DWPD) с использованием SLC NAND. Оно разработано для легкой интеграции с существующими приложениями искусственного интеллекта без необходимости внесения изменений в оборудование, что делает его доступным для компаний, ищущих экономически эффективные и мощные решения для обучения LLM.

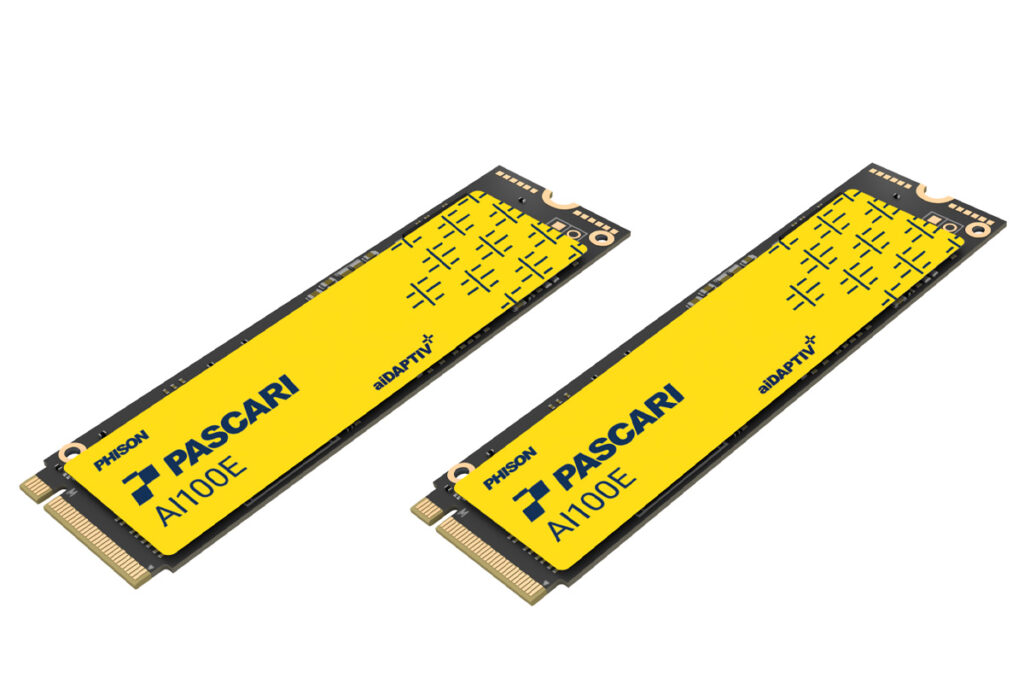

Семейство твердотельных накопителей Phison aiDAPTIVCache поддерживает модель 70B

Phison упоминает, что они использовали метод, аналогичный «перемещению» в операционных системах. Когда оперативная память компьютера заполнена, она перемещает редко используемые данные на жесткий диск, чтобы освободить место для активных процессов. Аналогично, aiDAPTIV+ использует высокоскоростные твердотельные накопители большой емкости (твердотельные накопители Phison AI100E M.2) для расширения возможностей памяти графических процессоров. Эти специально разработанные SSD или «aiDAPTIVCache» оптимизированы оптимизированы для высоких требований к обработке данных с помощью искусственного интеллекта.

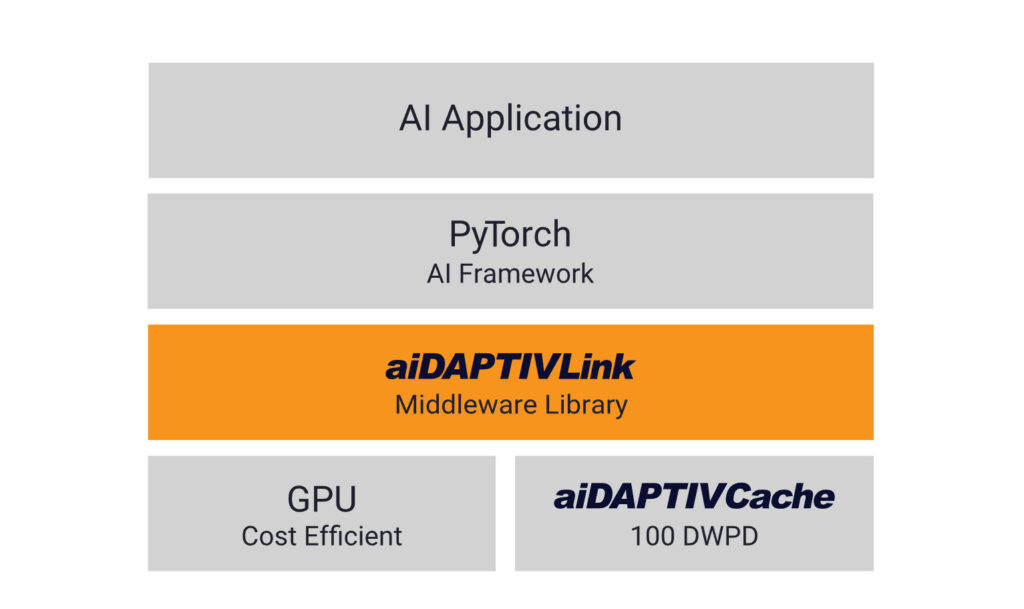

С другой стороны, промежуточное ПО aiDAPTIV+ управляет потоком данных между памятью GPU и SSD. Оно анализирует потребности модели искусственного интеллекта, определяет менее активные сегменты данных и переносит их на SSD, фактически создавая огромный виртуальный пул памяти для GPU. Эта технология позволяет обучать гораздо большие модели, чем это было бы возможно с GPU на плате.

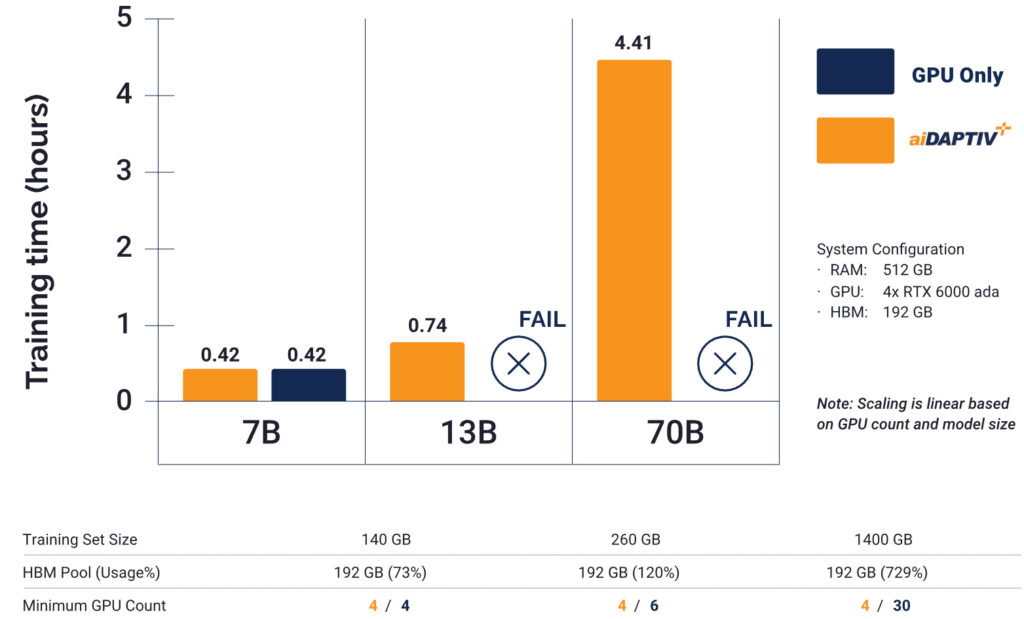

Сравнение времени обучения Phison только на GPU и aiDAPTIV+

На диаграмме показано время обучения для больших языковых моделей разных размеров — 7B, 13B и 70B. На графике показано, что при использовании только графических процессоров не удалось бы обучить модель a70B с использованием 4x RTX6000 Ada, в то время как решение aiDAPTIV+ успешно обучило модель за 4,41 часа. Это улучшение достигнуто благодаря промежуточному программному обеспечению Phison, которое оптимизирует память графического процессора за счет нарезки модели, хранения отложенных фрагментов в aiDAPTIVCache и эффективной замены фрагментов между кэшем и графическим процессором.

Как упоминалось в начале, недавно выпущенная серия DLAP Supreme от ADLINK использует технологию Phison aiDAPTIV+ для решения проблем с памятью и производительностью в периферийных устройствах для генеративного искусственного интеллекта. Серия DLAP Supreme достигает в 8 раз более высокой скорости вывода и в 4 раза большей длины токенов, а также поддерживает обучение больших языковых моделей даже на устройствах с ограниченными конфигурациями памяти, такими как NVIDIA Jetson AGX Orin 32GB, использующих модель Gemma 27B. Это позволяет периферийным устройствам справляться с задачами, для которых обычно требуются высокопроизводительные графические процессоры, такие как H100 или A100. Несколько компаний, таких как ADLINK, Advantech , ASRock , ASUS и GIGABYTE, уже внедрили технологию Phison aiDAPTIV+ в свои решения.

Выражаем свою благодарность источнику из которого взята и переведена статья, сайту cnx-software.com.

Оригинал статьи вы можете прочитать здесь.