В условиях современной действительности, компания Nvidia развернула серию переговоров и анонсов в Интернете. Даже основной доклад стал виртуальным, популярная и традиционно бессвязная речь Дженсена была перенесена на YouTube. Конечно, легче освещать ключевые моменты в прямом эфире, находясь в офисе. Но, мы уже скучаем по личным встречам на конференциях и практическим демонстрациям.

В любом случае, в этом году на мероприятии было представлено впечатляющее количество анонсов с новой архитектурой Nividia Ampere как для центра обработки данных, так и для AI на грани, начиная с графического процессора A100 с архитектурой Ampere.

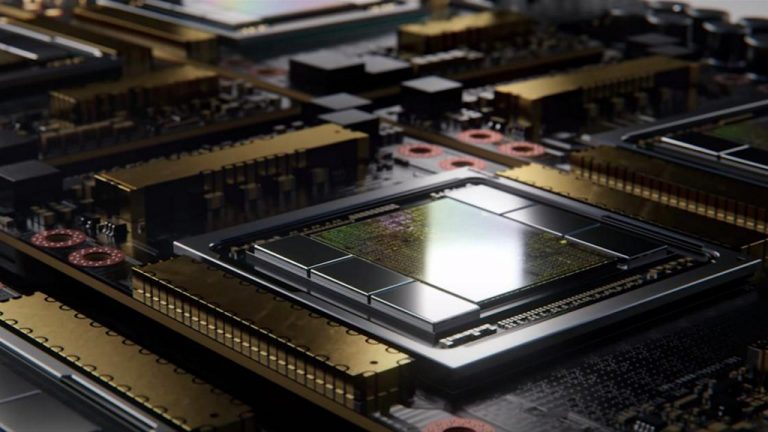

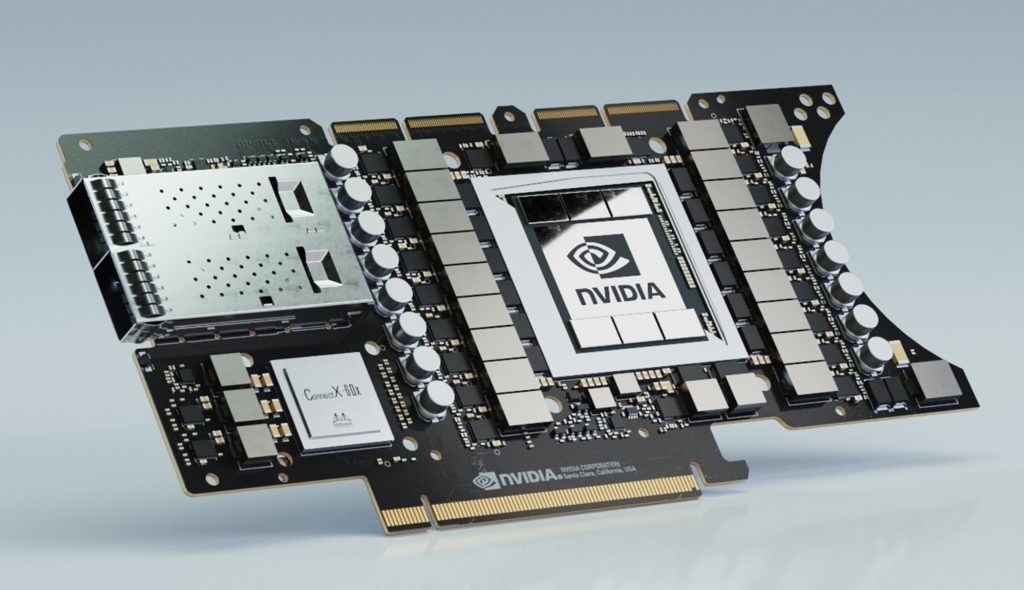

Nvidia A100: самый большой в мире 7-нм чип с 54 миллиардами транзисторов

Первый графический процессор Nvidia на базе процессора Ampere — новый A100 от компании, также является крупнейшим в мире и самым сложным 7-нм чипом с потрясающими 54 миллиардами транзисторов. Nvidia заявляет о приросте производительности до 20 раз по сравнению с предыдущими моделями Volta. A100 не только для искусственного интеллекта, поскольку Nvidia считает, что это идеальное устройство GPGPU для таких приложений, как анализ данных, научные вычисления и облачная графика. Для более легких задач, таких как логический вывод, один A100 может быть разделен на семь секций для параллельной работы нескольких нагрузок. И наоборот, NVLink позволяет тесно связать несколько A100.

Все ведущие поставщики облачных технологий, включая Google, Amazon, Microsoft и Baidu, заявили, что планируют поддерживать A100. Microsoft уже планирует выйти за рамки своего Turing Natural Language Generation, перейдя для обучения на A100s.

Инновационный TF32 направлен на оптимизацию производительности ИИ

Наряду с A100, Nvidia выпускает новый тип реализации с плавающей точкой одинарной точности — TF32 — для тензорных ядер A100. Это гибрид FP16 и FP32, целью которого является сохранение некоторых преимуществ производительности при переходе на FP16 без потери как можно большей точности. Новые ядра A100 также будут напрямую поддерживать FP64, что делает их все более полезными для различных приложений HPC. Наряду с новым форматом данных, A100 также поддерживает разреженные матрицы, так что сети AI, которые содержат много неважных узлов, могут быть представлены более эффективно.

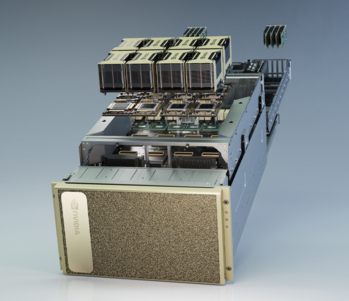

Nvidia DGX A100: 5 PetaFLOPS в одном узле

Наряду с A100, Nvidia анонсировала свой новейший компьютер для центров обработки данных — DGX A100, серьезное обновление свои текущих моделей DGX. Первый DGX A100 уже используется в Аргоннской национальной лаборатории Министерства энергетики США, чтобы помочь в исследовании COVID-19. Каждый DGX A100 имеет 8х графических процессоров A100, обеспечивая 156 TFLOPS производительности FP64 и 320 ГБ памяти GPU. По цене «только» (по их словам) 199 000 долларов. Межкомпонентные соединения Mellanox допускают развертывание нескольких графических процессоров, но один DGX A100 также может быть разбит на 56 экземпляров, что позволяет выполнять несколько небольших рабочих нагрузок.

В дополнение к собственному DGX A100, Nvidia ожидает от своих традиционных партнеров, в том числе Atos, Supermicro и Dell, встраивания A100 в свои собственные серверы. Чтобы помочь в этом, Nvidia также продает ускоритель обработки данных HGX A100.

Nvidia HGX A100 ускоритель обработки данных

HGX A100 включает базовые строительные блоки супер-компьютера DGX A100 в форм-факторе, подходящем для облачного развертывания. Nvidia делает несколько впечатляющих заявлений о повышении цены и производительности, которые могут ожидать ее облачные партнеры от перехода на новую архитектуру. В частности, о сегодняшних системах DGX-1, Nvidia сообщает, что типичный облачный кластер включает в себя 50 модулей DGX-1 для обучения, 600 процессоров для вывода и стоит 11 миллионов долларов, занимает 25 стоек и потребляет 630 кВт мощности. Как заявляют представители компании Nvidia, с Ampere и DGX A100, нужен только один тип компьютеров, а их гораздо меньше: 5 блоков DGX A100 для обучения и вывода стоимостью 1 миллион долларов, занимающих 1 стойку и потребляющих всего 28 кВт мощности.

DGX A100 SuperPOD

Конечно, если у вас гипермасштабируемый вычислительный центр, вам никогда не хватит мощности процессора. Таким образом, Nvidia создала SuperPOD из 140 систем DGX A100, 170 коммутаторов InfiniBand, сетевой матрицы 280 ТБ / с (с использованием 15 км оптического кабеля) и 4 ПБ флэш-памяти. Nvidia утверждает, что все это оборудование обеспечивает более 700 петафлопов производительности ИИ и было разработано Nvidia менее чем за три недели, чтобы использовать его для собственных внутренних исследований. Если у вас есть место и деньги, Nvidia выпустила эталонную архитектуру для своего SuperPOD, чтобы вы могли создать свою собственную. Джоэл и мы думаем, что это звучит как предпосылки создания отличного DIY-устройства, которое должно быть в состоянии запустить масштабный проект Deep Space Nine примерно за минуту.

Nvidia расширяет свой суперкомпьютер SaturnV

Конечно, Nvidia также значительно расширила свой суперкомпьютер SaturnV, чтобы воспользоваться преимуществами Ampere. SaturnV состоял из 1800 систем DGX-1, но теперь Nividia добавила 4х DGX A100 SuperPOD, доведя SaturnV до заявленной общей емкости 4,6 экзафлопсах. Согласно Nvidia, это делает его самым быстрым суперкомпьютером с поддержкой ИИ в мире.

Jetson EGX A100 выводит A100 на грань

Ampere и A100 не ограничены центром обработки данных. Nvidia также анонсировала мощный специализированный графический процессор для периферийных вычислений. Jetson EGX A100 построен на базе A100, но также включает в себя высокопроизводительное соединение Mellanox CX6 DX, которое защищено с помощью криптографических методов защиты информации. Графический процессор также включает поддержку зашифрованных моделей для защиты интеллектуальной собственности OEM-производителя. Обновления наборов инструментов Nvidia на базе Jetson для различных отраслей промышленности (включая Clara, Jarvis, Aerial, Isaac и Metropolis) помогут OEM-производителям создавать роботы, медицинские устройства и ряд других высокотехнологичных продуктов с использованием EGX A100.

Выражаем свою благодарность источнику из которого взята и переведена статья, сайту extremetech.com.

Оригинал статьи вы можете прочитать здесь.