Искусственный интеллект обрабатывается на разных уровнях в экосистеме с помощью сверхмощных систем на облаке, оснащенных специальным оборудованием, таким как карты FPGA или GPU, в то время как, с другой стороны, у нас есть процессор на базе Arm или RISC-V с AI -ускорителем для систем с низким энергопотреблением, таких как смартфоны или интеллектуальные камеры с питанием от батареи.

Компания Centaur Technology стремится предоставить решение для среднего сегмента устройств, которое не требует сверхнизкого энергопотребления или максимально возможной пиковой производительности, но все же требует относительно компактного форм-фактора и низких затрат .

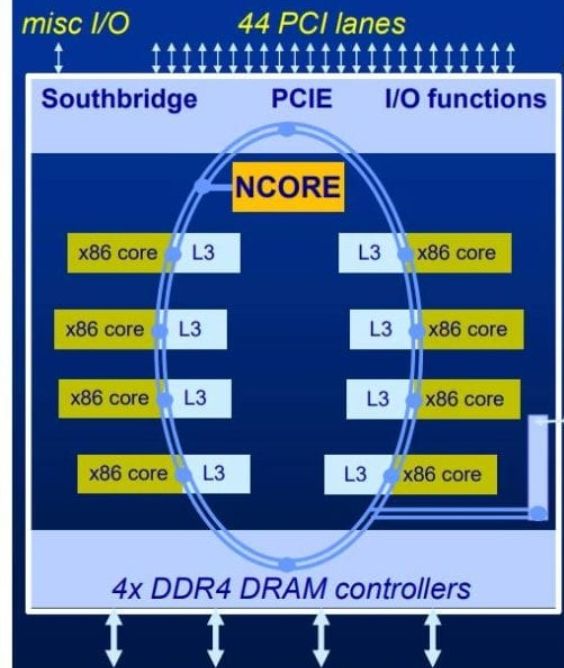

У решения еще нет имени – это восьмиъядерный процессор x86 с сопроцессором Centaur NCORE с искусственным интеллектом. SoC со встроенным NPU (процессор обработки нейронных сетей) довольно распространен в мире Arm и RISC-V, но, по-видимому, он впервые в мире x86, поскольку все существующие решения основаны на внешних ускорителях.

Ключевые особенности x86-совместимого процессора с искусственным интеллектом от Centaur :

- Микропроцессор x86 с высокими инструкциями / тактовой частотой (IPC)

- Микроархитектура, разработанная для приложений серверного класса с такими расширениями, как AVX-512

- Новая x86-совместимая технология теперь испытана с восьмиядерным CPU с тактовой частотой 2,5 ГГц (на эталонной платформе) и 16 МБ кэш-памяти L3

- Интерфейс системной памяти – 4-х канальная память DDR4 PC3200

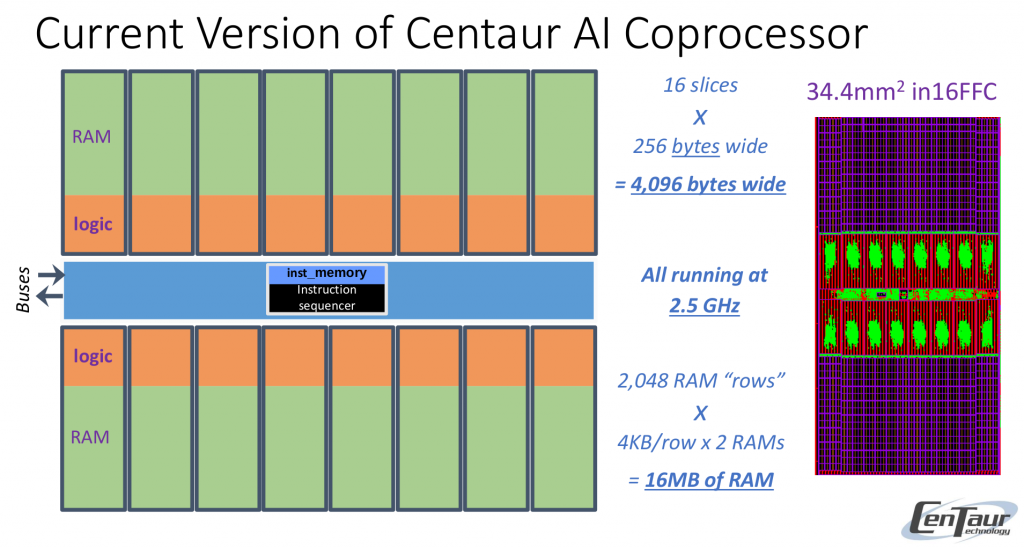

- Сопроцессор с искусственным интеллектом – ускоритель искусственного интеллекта NCORE с «очень широкой SIMD-архитектурой 32 768 бит», обеспечивающий пиковую производительность 20 TOPS и 20 терабайт/с благодаря выделенной 16 МБ памяти SRAM

- Расширение – 44x линии PCIe

- Занимаемая площадь – 195 кв. мм в 16-нм TSMC

Компания отмечает, что интегрированное решение лучше, чем внешние ускорители, поскольку они добавляют задержку, стоимость, мощность, место на плате, еще одну точку отказа.

В настоящее время процессор поддерживает TensorFlow Lite с кодом, работающим как на ядрах x86, так и на AI-ускорителе NCORE. Centaur также планирует поддержку большего числа фреймворков, включая TensorFlow и PyTorch, и компания далее объясняет, что в ее дорожной карте основное внимание уделяется использованию MLIR (Machine Learning Intermediate Representation) как для оптимизации на уровне схем, так и для генерации кода.

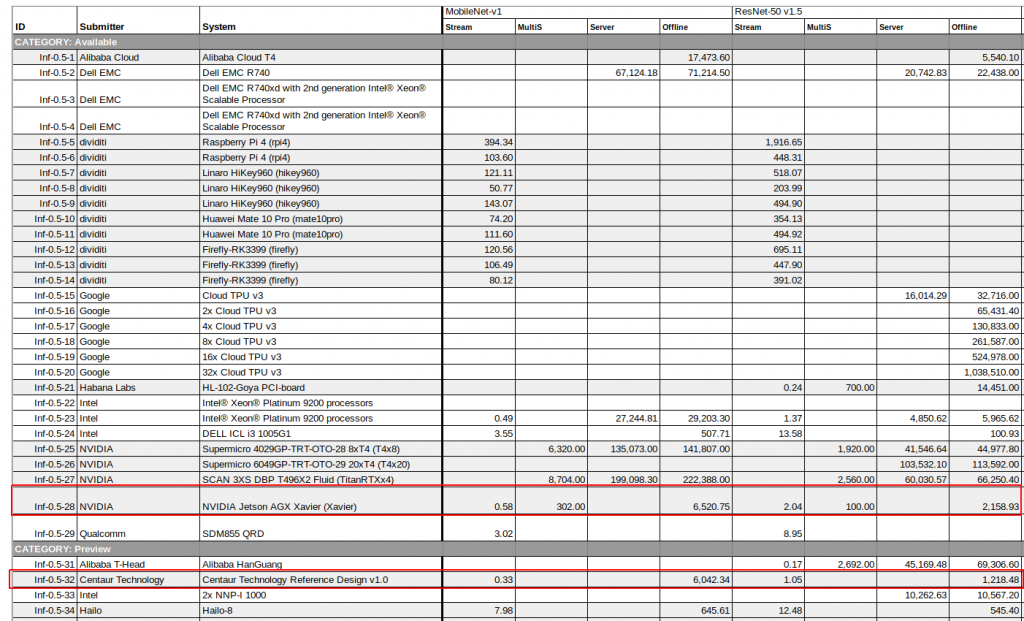

Справочная система Centaur использовалась для предоставления официальных, проверенных (предварительных) результатов в MLPerf и показала, что сопроцессор с искусственным интеллектом Centaur может классифицировать изображение менее чем за 330 микросекунд в MobileNet v1.

Если посмотреть результаты на сайте MLPerf , то Centaur x86 AI SoC, похоже, относится к тому же классу, что и NVIDIA Jetson AGX Xavier, хотя последний в ResNet-50 v1.5 примерно в два раза быстрее. Столбцы Stream показывают время, необходимое для визуализации отдельного потока в миллисекундах (то есть чем меньше значение, тем лучше), в то время как столбцы Offline выражаются во входах в секунду (то есть, чем выше, тем лучше).

Для сравнения, системы на базе Arm, которые не оснащены AI -ускорителями (например, Raspberry Pi 4, SBC RK3399), могут воспроизводить кадр примерно за 100 мс в MobileNet v1 или примерно в 300 раз медленнее, чем решение Centaur. С другой стороны, высокопроизводительные системы, такие как Google TPU, могут получить гораздо более высокую пропускную способность – до одного миллиона входов в секунду по сравнению с чуть более 1000 для Centaur SoC (компания отмечает, что показатели пропускной способности еще не оптимизированы, и, в конечном итоге, они ожидают 1400 кадров в секунду на модели RestNet-50).

Типичные приложения для новых процессоров включают локальные или частные центры обработки данных для приложений, использующих защищенное видео, медицинские изображения или другие конфиденциальные данные, «серверы Edge Analytics», выполняющие логический вывод для нескольких потоков данных, таких как камеры или IoT-датчики.

Более подробную информацию можно найти на странице продукта и слайдах презентации.

Выражаем свою благодарность источнику из которого взята и переведена статья, сайту cnx-software.com.

Оригинал статьи вы можете прочитать здесь.