В развитии Edge computing на Raspberry PI были взлеты и падения, особенно с проникновением искусственного интеллекта везде. Сама по себе плата Raspberry Pi, на самом деле, не способен поддерживать надежные AI-приложения. Типичное обнаружение объектов на Raspberry Pi даст вам примерно 1 — 2 кадра в секунду в зависимости от вашей модели, и это потому, что вся обработка выполняется на CPU.

Чтобы устранить низкую производительность AI-приложений на Raspberry Pi, на помощь пришли AI-ускорители. Intel Neural Compute Stick 2 — это один из таких ускорителей, способный работать со скоростью 8-15 кадров в секунду в зависимости от вашего приложения. NCS2, основанный на технологии Myriad X VPU, предлагает гораздо больше, чем предоставляет compute stick — это то, что команда разработчиков DepthAI использовала для создания мощного AI-модуля для периферийных вычислений под названием DepthAI .

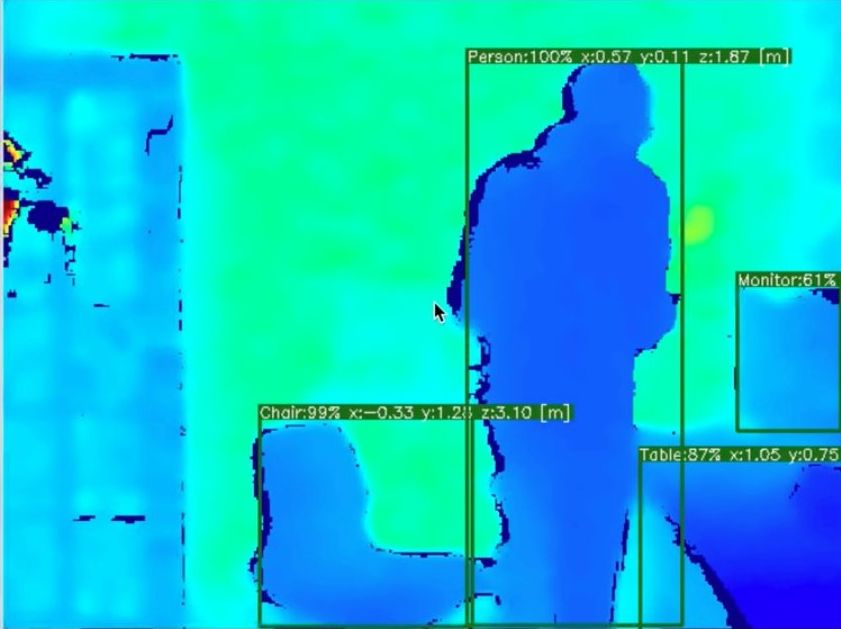

Одно дело — обнаружить объект. Совсем иное — локализация в материальном мире, существенная функция для мобильных роботов, и это то, что должен обеспечить DepthAI. DepthAI — это встроенная платформа для объединения Depth и AI, построенная на базе Myriad X VPU.

DepthAI — это встраиваемая платформа, разработанная Luxonis, участствовавшем в конкурсе разработчиков Microchip Get Launched 2019 и Hackaday Price в 2019 году. Инициатива зародилась из стремления повысить безопасность велосипеда, создавая велосипедный фонарь с искусственным интеллектом, который обнаруживает и предотвращает столкновения сзади.

DepthAI — это платформа, построенная вокруг Myriad X, сочетающая в себе восприятие глубины, обнаружение объектов (нейронный вывод) и отслеживание объектов, в простом и удобном в использовании API-интерфейсе Python.

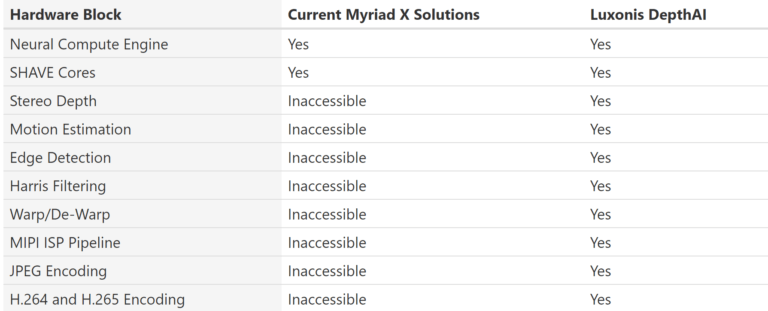

В основе устройства лежит Myriad X SOM, тот же модуль, который питает Intel Neural Compute Stick 2. В отличие от compute stick, некоторые возможности Myriad не используются; например, полосы MIPI и некоторые другие функции, что отражено на рисунке ниже. Благодаря интеграции, DepthAI позволяет в полной мере использующей возможности Myriad X для обработки изображений со скоростью четыре триллиона операций в секунду.

Локализация объектов в материальном мире возможна на модуле со скоростью 25 кадров в секунду, где можно получить координаты x, y, z (декартовы) в метрах. Эта функция возможна благодаря двум камерам MIPI, разделенным между собой. Устройство также поставляется с сопутствующей RGB-камерой.

DepthAI поставляется в виде системы-на-модуле с идеей сделать возможным интеграцию в любую пользовательскую встраиваемую платформу. Помимо модуля, DepthAI также доступен в 3 вариациях:

- Полностью интегрированное решение с встроенными камерами, которые работают при загрузке для упрощения создания прототипов (работает на Raspberry Compute Module 3+)

- Raspberry Pi HAT с модульными/дистанционными камерами.

- Интерфейс USB3, который можно использовать с любым хостом.

В комплект Raspberry Pi Compute Module Edition входит все необходимое: предварительно откалиброванные стерео-камеры совместно с цветной камерой 4K, 60 Гц и карта microSD с кодом Raspbian и DepthAI Python, автоматически запускающимся при загрузке. Pi HAT Edition позволяет пользователям подключать модуль к Raspberry Pi, у которого есть HAT, а камеры смонтированы на самой HAT. USB3 Edition позволит вам использовать DepthAI с любой платформой только через одно USB-соединение.

Некоторые из возможных функций DepthAI:

- Локализация объектов

- Обнаружение объекта

- Глубина видео или изображения

- Цветное видео или изображение

- Стереопара видео или изображение

DepthAI работает с OpenVINO для оптимизации нейронных моделей, как и в NCS2. Это позволяет вам тренировать модели с любыми популярными фреймворками, такими как TensorFlow, Keras и т. д., а затем использовать OpenVINO, чтобы оптимизировать их для эффективной работы и с низкой задержкой в DepthAI/Myriad X.

Краудфандинговая кампания DepthAI в настоящее время занимается на Crowd Supply. SoM можно приобрести за 99 долларов, USB3 Edition за 149 долларов, HAT Edition за 149 долларов и полную версию за 299 долларов. Если кампания будет успешной, доставка ожидается с февраля 2020 года.

Выражаем свою благодарность источнику из которого взята и переведена статья, сайту cnx-software.com.

Оригинал статьи вы можете прочитать здесь.