Одним из самых популярных приложений искусственного интеллекта является обнаружение объектов. Есть модели, способные обнаруживать объекты или предметы, такие как кошки, собаки, автомобили, ноутбуки или другие. Как указано в пресс-релизе Gyrfalcon, есть нечто подобное для видео под названием CDVA (компактные дескрипторы для анализа видео), способные анализировать происходящее и точно описывать ситуацию.

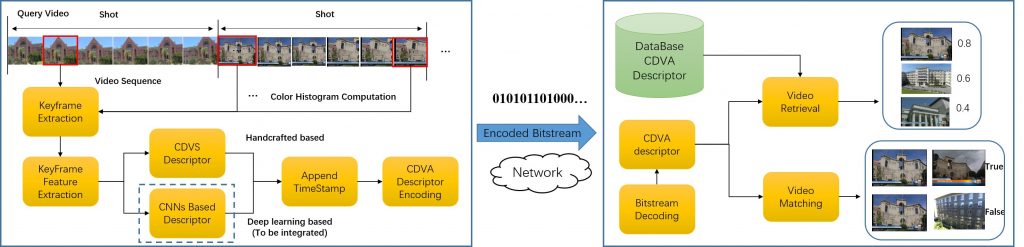

Стандарт CDVA, также известный как MPEG ISO/IEC 15938-15, описывает, как функции видео могут быть извлечены и сохранены в виде компактных метаданных для эффективного сопоставления и расширенного поиска. Gyrfalcon опубликовал пресс-релиз, их линейка чипов Lightspeeur AI будет адаптирована к CDVA.

Вы можете получить технические подробности в этом документе, озаглавленном «Компактные дескрипторы для анализа видео: новый стандарт MPEG». CDVA, опираясь на CNN (свёрточные нейронные сети), сначала извлекает кадры, добавляет временную метку и закодированный дескриптор CDVA к видео, которое отправляется на сервер или в облако для анализа.

Если вам интересно, что такое CDVS:

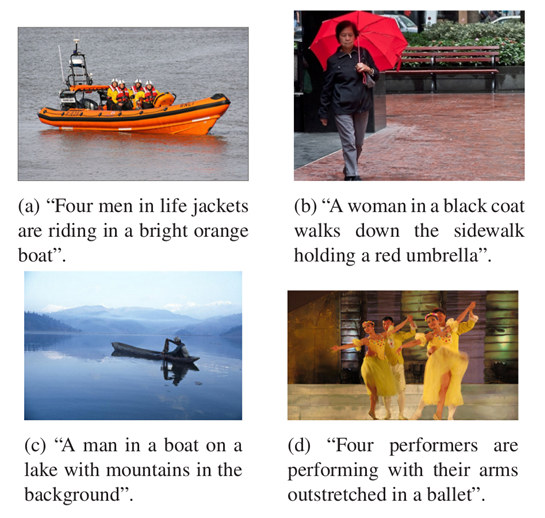

MPEG-CDVS обеспечивает стандартизированное описание функций дескрипторов и процесс извлечения дескрипторов для эффективных и совместимых приложений поиска неподвижных изображений. По сути, CDVS может служить описанием функции видео на уровне кадра, что способствует наследованию функций CDVS в исследовании CDVA.

Другими словами, как мы понимаем, CDVS предназначен для неподвижных изображений в видео, а анализ выполняется на грани. В то время как CDVA анализирует само видео, а тяжелая работа выполняется в облаке.

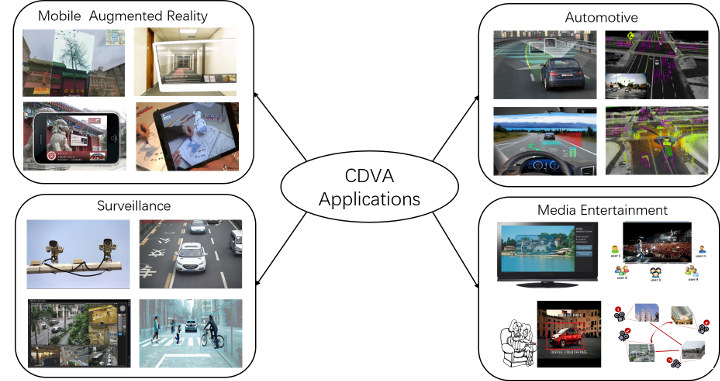

Типичные сферы применения — дополненная реальность, автомобильная промышленность, видеонаблюдение и развлечения. Например, сейчас мы используем PIR-камеру наблюдения, которая будет отправлять оповещения при обнаружении движения. Но, мы не будем знать, кот это, кролик, какие-то листья движутся или настоящий вор, пока не посмотрим видео, поэтому есть вероятность ложных срабатываний. Камера видеонаблюдения с поддержкой CDVA будет фильтровать кошек и кроликов и отправлять точные описания необычных событий, например — «люди в масках, подозрительно приближающиеся к дому» :).

Если вы помните, мы недавно писали о MPEG VCM (Видеокодировании для машин), специально разработанном для приложений M2M и H2M (человек-машина), и группа MPEG, работающая над проектом, также говорит о приложении CDVA под названием SuperCDVA, которое выполняет понимание видео с использованием временной информации.

SuperCDVA все еще находится на стадии разработки и будет обсуждаться на собрании MPEG-128 в Женеве 7 октября 2019 года. Вы можете прочитать «SuperCDVA для MPEG128» (PDF) для получения более подробной информации.

Видео ниже демонстрирует SuperCDVA в действии, анализирование видео «на лету». Для анализа видео с помощью решения Gyrfalcon (GTI) требуется от 2 до 3 секунд.

Выражаем свою благодарность источнику из которого взята и переведена статья, сайту cnx-software.com.

Оригинал статьи вы можете прочитать здесь.